Googleが毎年開いている開発者向けイベント「Google I/O」が、今年も開催されました!

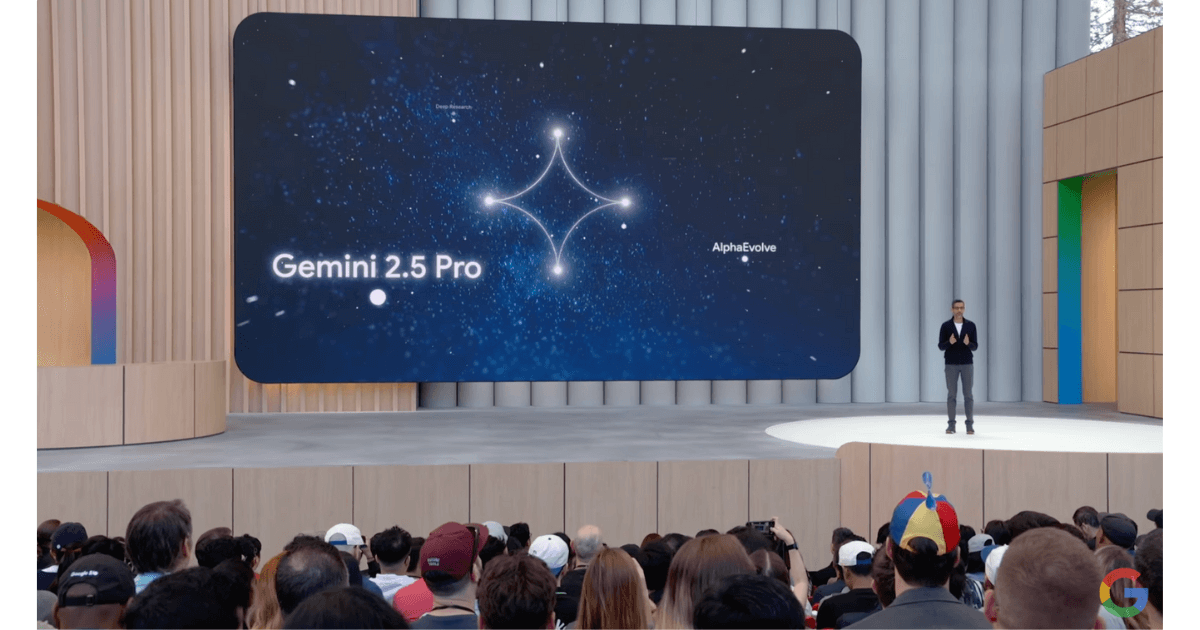

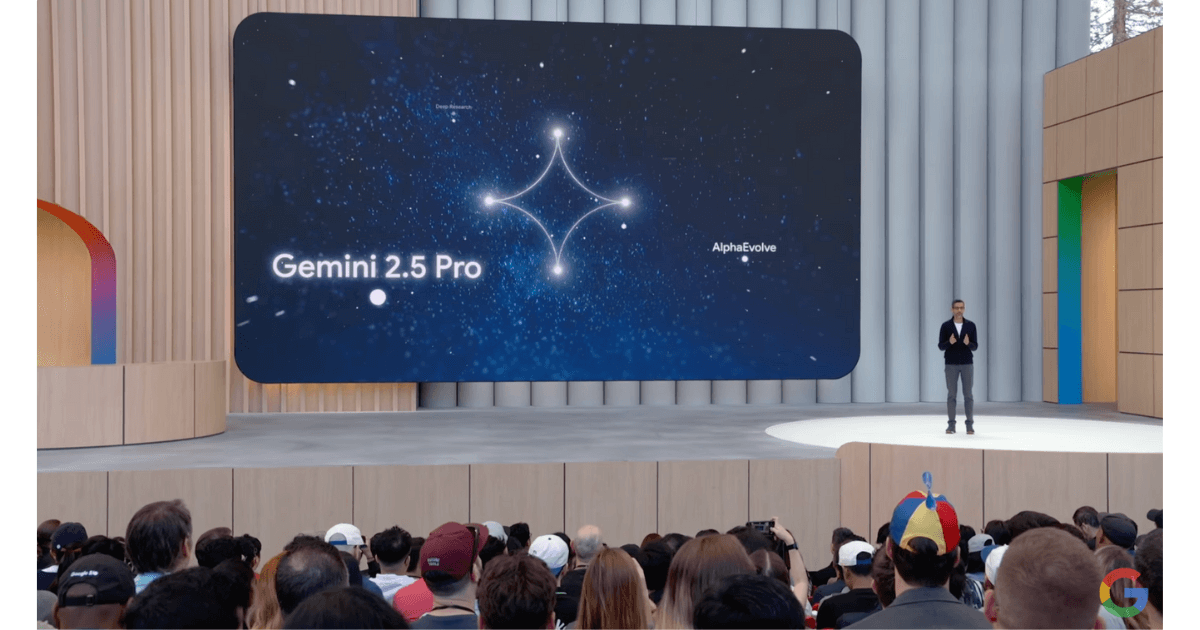

今回の発表では、注目の「Gemini 1.5 Pro」や「Project Astra」、そして会話型サービス「Google Beam」など、気になる内容が盛りだくさんです。

どれもAIを使って日常がちょっとラクになるようなサービスばかりで、スマホやPCをよく使う方にはぜひチェックしてほしい内容です。

この記事では、それぞれのポイントをわかりやすく紹介していきます。どんな場面で役に立ちそうかも、イメージしやすくまとめていますので、気軽に読んでみてください!

モモちゃん

モモちゃん-150x150.png)

-150x150.png)

-150x150.png)

-150x150.png)

-150x150.png)

-150x150.png)

Google I/O 2024の注目ポイント

Google I/Oでは、便利なAIサービスがいくつも発表されたよ。「Gemini 1.5 Pro」は長い文を読んだり、「Project Astra」はカメラで見たものを理解したり、「Google Beam」は自然な会話ができるんだ。毎日の生活がちょっとラクになるような使い方ができるよ。

-150x150.png)

-150x150.png)

-150x150.png)

Project Astraって、見たものにすぐ答えてくれるんだにゃ!それって…ぼくのオモチャも分かるのかにゃ?

-150x150.png)

-150x150.png)

-150x150.png)

Google Beamって、なんだかおしゃべり好きな相棒みたいなのね。言わなくても先に気づいてくれるなんて、ちょっと助かる気がするわ。

うん、どのサービスも“わかりやすさ”が大事にされてるよ。ふだんのやりとりの中で自然に使えるっていうのがポイントなんだ。

2024年のGoogle I/Oでは、AIを使った便利なサービスがいくつも発表されました。

なかでも注目されたのは、テキストや音声、カメラの情報を使って会話できる「Project Astra」、長い文もスムーズに処理できる「Gemini 1.5 Pro」、そして自然な会話ができる「Google Beam」です。

これらは、使いやすさを重視しながら、日常のあらゆる場面に寄り添うように作られています。Googleはこれらを通して、誰もが無理なくAIを活用できる環境を目指しています。

この記事では、それぞれのサービスがどんなことに使えそうか、身近な例を交えながら紹介していきます。

Project Astraは会話型のカメラAI

Project Astraは、音声と映像をリアルタイムで処理して、まわりの様子をすぐに理解して答えてくれるAIです。

たとえば、スマホのカメラを向けて「これ何?」と聞くと、その物をすぐに教えてくれます。さらに、場所や状況に合わせて自然に返してくれるので、まるで人と話しているような感覚になります。

今回のGoogle I/Oでは、実際に使っている様子も紹介されていて、その反応の速さとスムーズな会話に驚きの声があがっていました。難しい操作がいらず、誰でもすぐに使えるのが魅力です。

スマホがより身近なパートナーになっていく様子を感じさせるサービスです。

Gemini 1.5 Proは処理能力がパワーアップ

Gemini 1.5 Proは、文章やコード、音声など、いろいろな情報をまとめて処理できる点が特長です。前のバージョンよりも、より長くて複雑な内容にも対応できるようになりました。

たとえば、100ページ以上ある資料の中から必要な部分だけをすぐに見つけたり、過去の会話をふまえて自然に続きが話せたりします。今回のGoogle I/Oでは、これまでのAIと比べてずっとスムーズで反応も早いと紹介されていました。

仕事や勉強でたくさんの情報を扱う方にとって、頼れるパートナーになりそうです。

Google Beamで自然な会話ができる

Google Beamは、チャットアプリのような画面で、まるで友達とやりとりするような自然な会話ができるサービスです。

自分が使っているアプリや画面の情報をもとに、今必要なことをすぐに提案してくれるのがポイントです。

たとえば、メールの下書きを一緒に考えたり、カレンダーの予定を提案してくれたりと、やりたいことを先回りしてサポートしてくれます。

Googleはこのサービスを「毎日使うアシスタント」にしていきたいと考えていて、ユーザーの使い方に合わせて変化していくのが魅力です。これからの使い方に注目が集まっています。

Gemini 1.5 Proの実力と活用

Gemini 1.5 Proは、長い文章や会話もまとめて理解できるんだ。しかも、動画や画像も読み取れるから、いろんな場面で手助けしてくれるよ。

-1-150x150.png)

-1-150x150.png)

-1-150x150.png)

すごいにゃ~!ぼくがしゃべったことをずっと覚えてくれてるなら、何回も説明しなくていいにゃ!

-150x150.png)

-150x150.png)

-150x150.png)

動画までわかるなんて、ちょっとびっくりだわ。お料理動画の手順も教えてくれたら助かるのにね。

うん、そういう使い方もできると思うよ。会話の流れも自然になるから、いろんなサービスに合いそうだね。

今回のGoogle I/Oで注目されたGemini 1.5 Proは、これまでよりも長い情報を扱えるようになった点が大きなポイントです。

動画の内容をそのまままとめたり、100ページ以上ある文書を読み込んで理解することができるようになりました。

また、Geminiは開発者向けにも使いやすく設計されていて、さまざまなアプリやサービスに取り入れやすくなっています。

GoogleはGemini 1.5 Proを通して、日常のやりとりから仕事まで、より幅広い場面での活用を広げようとしています。

このパートでは、Geminiの性能や、どんなことに使えるのかを実例を交えながら紹介していきます。

長い会話や文書もスムーズに理解

Gemini 1.5 Proは、以前よりもはるかに多くの情報を一度に処理できるようになっています。

たとえば、1時間以上の会話内容をそのまま覚えておいて、あとから質問に答えることもできますし、分厚い資料を全部読んで、要点だけをまとめてくれることも可能です。

これにより、面倒な確認作業や読み直しが少なくなり、作業効率がぐんとアップします。実際にGoogleのデモでは、100ページを超える法律文書を一気に要約して見せており、多くの人が驚いていました。

情報が多い場面ほど、Geminiの良さが発揮されそうです。

さまざまなアプリに組み込みやすい

Gemini 1.5 Proは、開発者が使いやすい形で提供されているのも特長です。

Googleの提供する「Gemini API」を使えば、自分のアプリやサービスにGeminiの機能を組み込むことができ、AIアシスタントのような動きが実現できます。

たとえば、チャットサービスに導入すれば、過去の会話の流れをふまえて返事をしたり、ユーザーに合った情報を出したりすることができます。開発のハードルが下がったことで、個人でも企業でも、幅広い場面で取り入れられるようになっています。

今後は、身近なサービスにも続々と導入されていくかもしれません。

動画や画像も理解できるAIへ

Gemini 1.5 Proは、テキストだけでなく、動画や画像の内容も理解して答えてくれるのが大きな特長です。

たとえば、動画を見せて「この人はどんな動きをしてるの?」と聞くと、映像を分析して内容を説明してくれるのです。

これにより、動画編集や教育、監視カメラのチェックなど、いろいろな場面で役立つ可能性があります。さらに、複数の情報を組み合わせて判断できるため、より自然なやりとりが可能になります。

Googleはこの方向にも力を入れていて、将来的にはより多くのサービスで画像や映像の理解機能が使えるようになりそうです。

Project Astraの機能と活用

-150x150.png)

-150x150.png)

-150x150.png)

-150x150.png)

-150x150.png)

-150x150.png)

Project Astraは、映像と音声の両方をリアルタイムで理解し、ユーザーとの自然なやりとりができる次世代のAIアシスタントです。

スマホのカメラを通して見たものにすぐ反応したり、「これ何?」と聞けばその場で説明してくれたりと、視覚と会話をつなぐ動きが特徴です。Google I/O 2024では、実際のデモ動画を通して、質問に即座に答える様子や、目の前の状況を理解して判断する動きが紹介され、多くの注目を集めました。

このパートでは、Project Astraの基本的な機能、使えるシーン、そして現時点での課題や注意点について、わかりやすくまとめていきます。

リアルタイム理解のすごさ

Project Astraのいちばんの特長は、リアルタイムでまわりの状況を理解して反応できるところです。

カメラを通して映っている物をすぐに認識して、「これは何か」「どこにあるか」を答えてくれます。たとえば、リモコンを見せて「これどこに置いたっけ?」と聞くと、さっき見た場所を思い出して教えてくれるような動きが紹介されました。

言葉だけでなく、映像を手がかりに判断してくれるので、日常のちょっとした「わからない」「探したい」に応えてくれます。

こうした機能は、日常生活を少しラクにするサポートとして、身近に感じやすいのが魅力です。

使えるシーンが広がりそう

Project Astraは、家庭や職場など、いろんな場所での活用が期待されています。

たとえば、料理中にレシピを確認しながら「これって次何するんだっけ?」と聞けば、映像と音声をもとに説明してくれるかもしれません。また、子どもが「これなに?」と聞いたときに、すぐに答えてくれる補助役にもなれそうです。

会話を続けながら映像も読み取れるので、手が離せない作業中にも役立ちます。普段のやりとりにちょっとプラスするような形で使えるのが、Project Astraの面白さでもあります。

人とのやりとりに近づけることを意識した設計がうかがえます。

期待されるけど注意も必要

便利な一方で、Project Astraを使う上での注意点もあります。

映像と音声を使うということは、それだけ多くの情報を扱うことになるため、プライバシーの扱いが大切になります。どこまで記憶しているのか、どの場面まで理解するのかといった点は、使う人がきちんと把握しておく必要があります。

また、現在の段階ではまだ開発中の部分も多く、実際のサービスとして安定して使えるようになるまでは、もう少し時間がかかるかもしれません。

期待が集まる分、使い方のバランスや信頼できる場面選びも大事になりそうです。

Google BeamとAIアシスタント

Google Beamはね、チャットで自然に話せるアシスタントなんだ。カレンダーの予定を教えてくれたり、今見てる画面に合ったことを提案してくれたりするんのよ。

-150x150.png)

-150x150.png)

-150x150.png)

話しかけるだけで予定を教えてくれるの、めっちゃ便利にゃ!でも、ぜんぶ見られてるって思うとちょっとドキドキするにゃ〜!

-150x150.png)

-150x150.png)

-150x150.png)

うふふ、わたしも気になっちゃうかも。何を見てるのか分からないと、ちょっと落ち着かないのよね。でも手が離せないときに話すだけで使えるのは助かるわ〜。

うん、だからこそ、使うときは仕組みもちゃんと知っておくのが大事だよね。便利だけど、自分で確かめる気持ちも忘れないでおきたいな。

Google I/O 2024で紹介されたGoogle Beamは、自然な会話ができる対話型AIアシスタントです。

今までは調べ物をするときに検索を使うのが普通でしたが、Google Beamではまるで人と話すように質問や相談ができるのが特長です。ユーザーが見ている画面や使っているアプリの状況をふまえて返答してくれるので、よりリアルタイムでスムーズなやりとりが可能になります。

ただし、どこまで正確に読み取れるかや、情報の取り扱いに不安を感じる人もいるかもしれません。

このパートでは、Google Beamの魅力と注意点、そして日常生活や仕事でどう役立つかをまとめていきます。

自然な会話で使いやすさアップ

Google Beamは、チャット画面を通して話しかけると、まるで人と話しているような返答をしてくれます。

キーワードを入力する必要がなく、普段の口調で話しかければいいので、AIがはじめての人でも使いやすいのがポイントです。

たとえば「今週の予定どうなってる?」と聞くと、カレンダーの内容をもとに予定を教えてくれたり、「このメール返信したほうがいい?」と相談することもできます。機械っぽさを感じさせないやりとりができることで、自然に使う場面が増えていきそうです。

操作がシンプルなので、スマホになじみのある世代には特に便利だと感じられるはずです。

便利な反面、気になることも

Google Beamは便利な一方で、気になる点もあります。

たとえば、ユーザーの操作内容やアプリの情報をもとに返答する仕組みなので、どこまで情報を見られているのか不安に思う人もいるかもしれません。

また、会話の内容によっては、うまく意図が伝わらなかったり、誤解されることもあります。こうしたときには人のように言い直しが必要になる場面もありそうです。

使い方によってはとても役に立ちますが、すべてを任せきりにするのではなく、自分で確認する意識も大事になってきます。

安心して使うためには、仕組みをある程度知っておくことも必要です。

日常や仕事での使い道は?

Google Beamは、日常生活から仕事まで、いろいろな場面で使える可能性があります。

たとえば、忙しい朝にスケジュールを読み上げてもらったり、メールの下書きをサッと手伝ってもらったりと、手が離せないときにも便利です。会話で操作できるので、手間をかけずに情報を得ることができます。

職場では、プロジェクトの進行状況をまとめたり、会議のメモを整理する役割もこなせるかもしれません。

ただし、情報の正確さや内容のチェックは人が行う必要があるため、補助的なツールとして活用するのがよさそうです。うまく取り入れれば、毎日の作業がスムーズになるはずです。

まとめ:Google I/O 2024発表のAIアシスタント特集

今回のGoogle I/Oでは、Gemini 1.5 ProやProject Astra、Google Beamみたいに、毎日の中で役立ちそうなサービスがいろいろ紹介されたよ。わかりやすくて、使いやすさが大切にされてたのが印象的だったな。

-1-150x150.png)

-1-150x150.png)

-1-150x150.png)

スマホで話すだけで手伝ってくれるのって、すごく楽ちんそうにゃ!ぼくも使ってみたいにゃ〜!

-150x150.png)

-150x150.png)

-150x150.png)

ほんとね、こういうのって難しいかと思ってたけど、案外身近なことに使えるのね。使い方をちゃんと知っておけば、安心して試せそうのわ〜。

Google I/O 2024では、「Gemini 1.5 Pro」や「Project Astra」、「Google Beam」など、日常に役立つAIサービスがいろいろ発表されました。

どれも使いやすさが意識されていて、スマホやパソコンをもっと身近な存在にしてくれる内容ばかりです。情報をまとめたり、映像を見て答えてくれたり、話し相手みたいに相談にのってくれたりと、さまざまな使い方ができそうですね。

私もAIの進化にはすごくワクワクしています!でも、便利さの一方で、やっぱり気になるのが「使い方」や「情報の取り扱い」ですね。

たとえば、プライバシーやセキュリティのこと、誰がどこまで情報を見られるのか、ちゃんと理解しておかないと、後で困ることもあるかもしれません。便利なツールが増えると、どうしてもそれに頼りたくなっちゃうけど、自分のデータや情報を守ることは大事だと思います。

これからもこういったサービスが増えていくと思うので、自分に合ったものを上手に選んで、賢く使っていけたらいいですね。私は、使う前にちょっとだけ調べてみたり、試しながら覚えていこうと思っています!

どんどん進化するAIを、楽しみながら取り入れていきたいです。

従来の記事作成と異なり、AIを使うことで大量のデータから

最適な情報を選び出し、コスパ良く記事を生み出すことが可能です。

時間の節約、コスト削減、品質の維持。

AI記事作成代行サービスは、効率よく質の高い記事を作成いたします。

コメント